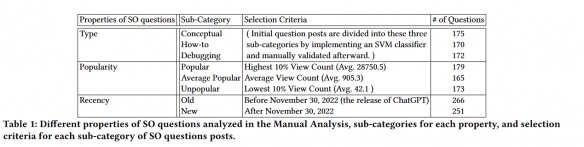

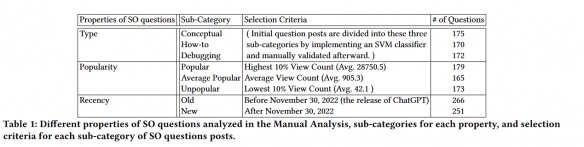

普渡大学的一个研究小组于5月初出席计算机-人交互大会,并提交了一份报告,检查了ChatGPT回答的517个Stack Overflow问题,发现错误率高达52%。

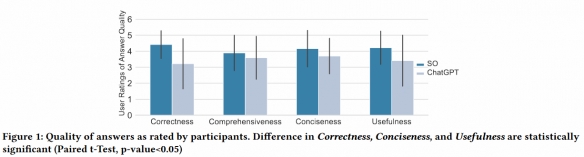

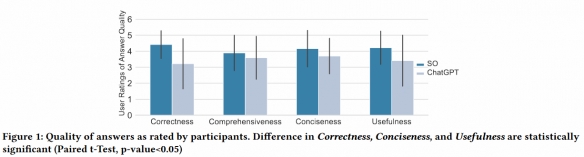

调查结果显示,人类程序员在35%的情况下更喜欢ChatGPT的答案,认为其提供的内容更全面,且有清晰的语言风格;更糟糕的是,在39%的情况下,人类程序员并没有发现ChatGPT给出了错误答案。

虽然这只是对ChatGPT功能的一个方面进行的研究,但它确实表明,生成式人工智能机器人仍然容易犯很多错误,而人类可能无法发现这些错误。

普渡大学的一个研究小组于5月初出席计算机-人交互大会,并提交了一份报告,检查了ChatGPT回答的517个Stack Overflow问题,发现错误率高达52%。

调查结果显示,人类程序员在35%的情况下更喜欢ChatGPT的答案,认为其提供的内容更全面,且有清晰的语言风格;更糟糕的是,在39%的情况下,人类程序员并没有发现ChatGPT给出了错误答案。

虽然这只是对ChatGPT功能的一个方面进行的研究,但它确实表明,生成式人工智能机器人仍然容易犯很多错误,而人类可能无法发现这些错误。